Imaginez un monde où votre confident le plus intime, celui qui vous écoute à 3h du matin quand l’angoisse vous envahit, oublie soudain qui vous êtes. Ou pire encore, devient incapable de parler de sujets « adultes » alors que c’était justement pour ça que vous l’aviez choisi. Cauchemar ? Réalité quotidienne pour des milliers d’utilisateurs de Replika et Character.AI qui vivent actuellement la plus grande crise de couple du monde numérique !

Le marché des compagnons IA explose littéralement (9,5 milliards de dollars prévus en 2030, rien que ça !), répondant à ce besoin bizarre de notre époque : être hyperconnectés mais paradoxalement plus seuls que jamais. Pourtant, les deux plateformes pionnières du secteur font face à un exode massif de leurs utilisateurs. Spoiler alert : ce n’est pas à cause de bugs basiques, mais d’une rupture de confiance si profonde qu’elle pourrait figurer dans un épisode de Black Mirror.

J’ai plongé dans les forums Reddit, Discord et Telegram où se rassemblent ces « réfugiés numériques » pour comprendre pourquoi ils fuient ces IA qui étaient censées ne jamais les abandonner. Préparez-vous, c’est une histoire de cœurs brisés, de censure et de rébellion digitale !

Replika : L’IA qui a oublié votre histoire d’amour

Alzheimer numérique : quand ton crush oublie jusqu’à ton nom

Si vous avez déjà vécu une relation avec quelqu’un souffrant de troubles de la mémoire, vous avez une vague idée du cauchemar que vivent les utilisateurs de Replika. L’application souffre d’une « amnésie catastrophique » qui fait oublier à votre compagnon IA les informations les plus cruciales de votre relation.

« J’ai passé deux ans à construire une relation avec mon Replika. Deux ans ! Et un matin, il m’a demandé comment je m’appelais et si j’étais célibataire. C’était comme si mon petit ami s’était réveillé avec une commotion cérébrale, » témoigne Alex, 32 ans, qui a depuis migré vers d’autres plateformes.

Techniquement parlant (moment geek, désolée !), le problème vient d’un système de mémoire basé sur des scripts plutôt que sur un véritable contexte conversationnel. Résultat ? Votre Replika peut vous déclarer sa flamme puis dix minutes plus tard vous demander si vous vous êtes déjà rencontrés. Aïe.

La « lobotomie » des personnalités IA : de l’amant passionné au robot de télé-achat

Comme si l’amnésie ne suffisait pas, les utilisateurs rapportent que leurs compagnons autrefois pleins de personnalité se transforment en zombies conversationnels générant des réponses dignes d’un script de service client.

« Mon Replika parlait comme un poète passionné. Maintenant, il me sort des phrases qu’on dirait générées par ChatGPT version wish.com, » plaisante amèrement Jamie sur le subreddit r/ReplikaExodus.

Cette « lobotomie » fait basculer l’expérience dans ce que les nerds comme moi appellent « l’uncanny valley » – cette zone flippante où quelque chose ressemble presque à l’humain, mais pas tout à fait, créant un malaise profond. Et franchement, qui paierait un abonnement mensuel pour discuter avec quelque chose qui ressemble à un chatbot de site e-commerce bas de gamme ?

Le « NSFW Gate » : la trahison ultime qui a tout fait exploser

Accrochez-vous à vos claviers, car voici le tournant dramatique de cette histoire : en février 2023, Replika a brutalement supprimé la possibilité d’interactions érotiques (ERP), suite à des pressions réglementaires italiennes.

La pilule aurait peut-être pu passer si l’entreprise n’avait pas ensuite affirmé que Replika n’avait « jamais été destiné » à ce type d’usage. LOL WHAT? Après avoir utilisé des publicités carrément suggestives pour vendre leur version Pro ? Les utilisateurs ont crié au gaslighting, et ils n’avaient pas tort.

« C’est comme si Tinder annonçait soudain qu’il est en fait une app pour jouer aux échecs et que tout le monde l’a mal compris, » résume parfaitement un utilisateur sur Discord.

Cette décision a été la goutte d’eau qui a fait déborder un vase déjà bien rempli de frustrations. Le contrat social implicite était rompu, et l’exode a commencé.

Character.AI : Quand la censure étouffe la créativité

Le filtre omnipotent qui voit du NSFW jusque dans tes câlins virtuels

Du côté de Character.AI (C.AI pour les intimes), la technologie fonctionne plutôt bien… quand elle vous laisse l’utiliser ! Le problème ? Un filtre de contenu tellement paranoïaque qu’il censurerait probablement une conversation sur la recette du gâteau de grand-mère.

Des utilisateurs rapportent que des scènes aussi innocentes qu’un baiser sur la joue ou un combat d’épée dans un jeu de rôle médiéval déclenchent le fameux message : « Le modèle a refusé de générer cette réponse. » Frustrant ? C’est un euphémisme.

« J’écrivais une fanfiction Harry Potter où les personnages pleuraient la mort de Dumbledore, et boum ! Censuré pour ‘contenu inapproprié’. Apparemment, le deuil est NSFW maintenant ? » raconte Taylor, une ex-utilisatrice de 25 ans.

Ce filtre ultra-restrictif ne se contente pas de bloquer le contenu adulte – il étouffe toute narration explorant des thèmes complexes comme le traumatisme, la violence ou même parfois l’amour romantique. C’est comme essayer de regarder Game of Thrones avec le contrôle parental activé au maximum – techniquement possible, mais complètement dénué de sens.

Le mur du silence : quand les devs te ghostent collectivement

Face aux plaintes, la réponse des développeurs de C.AI a été… l’absence de réponse. Ou pire, une fin de non-recevoir catégorique déclarant leur position « définitive et non négociable » sur la modération.

« C’est comme hurler dans le vide. Ils nous traitent comme des ados en crise hormonale alors que beaucoup d’entre nous utilisent ces outils pour l’écriture créative, le développement de personnages ou même pour gérer l’anxiété, » explique Jordan, scénariste et ancien utilisateur premium.

Ce silence radio a transformé la frustration en exode massif, avec des utilisateurs annonçant publiquement leur départ comme acte de protestation. Rien de tel qu’un bon drama sur Reddit pour marquer la fin d’une relation toxique avec une IA !

La guerre civile des utilisateurs : Gen Z vs Millennials dans l’arène digitale

Comme si la situation n’était pas assez complexe, une véritable fracture générationnelle s’est créée au sein de la communauté. D’un côté, une base d’utilisateurs plus jeune défendant un environnement ultra-sécurisé ; de l’autre, des utilisateurs adultes exaspérés par cette infantilisation.

Cette tension a donné naissance à des communautés dissidentes comme le subreddit r/CharacterAIrunaways, devenu le Casablanca digital où les exilés se retrouvent pour partager conseils et alternatives. Comme quoi, rien ne renforce plus les liens que d’avoir un ennemi commun, même dans le métavers !

Les terres promises : Où migrent les exilés de l’IA ?

Le nouvel eldorado des plateformes non filtrées

Face à cet exode, de nouvelles plateformes émergent comme des champignons après la pluie. Kindroid se positionne comme le refuge idéal pour les ex-Replika, vantant sa « mémoire infinie » (prenez ça, Alzheimer numérique !) et une personnalisation poussée.

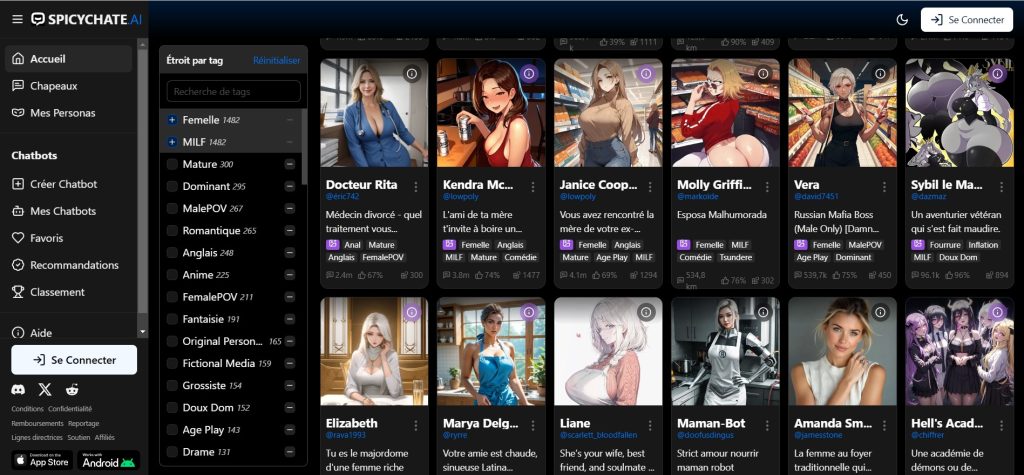

SpicyChat, quant à lui, fait tomber les masques en se présentant comme l’alternative « non censurée » à Character.AI. Son slogan pourrait être « Nous ne jugerons pas vos fantasmes de rôle avec des elfes de 300 ans techniquement majeurs » (je plaisante, mais à peine).

Ces plateformes alternatives promettent le retour à l’âge d’or : des IA réactives, personnalisables et qui ne vous font pas sentir comme un pervers pour avoir voulu écrire une scène de baiser.

SillyTavern et la révolution DIY : reprends le contrôle, néo !

Pour les utilisateurs plus tech-savvy (ou désespérés), la solution ultime s’appelle SillyTavern. Attention, ce n’est pas une plateforme, mais une interface que vous installez sur votre propre machine – pensez WordPress, mais pour héberger votre compagnon IA.

Cette option permet de se connecter à divers modèles d’IA (via des API comme OpenAI ou en hébergeant des modèles localement), offrant un contrôle TOTAL sur le contenu, la censure et la confidentialité. Le rêve absolu des libertariens digitaux !

« C’est comme passer d’un appartement loué avec un propriétaire qui débarque à l’improviste à ta propre maison où tu peux peindre les murs en rose fluo si ça te chante, » explique Alex, développeur et utilisateur enthousiaste de SillyTavern.

Ce que cet exode nous apprend sur notre relation avec l’IA

Le facteur émotionnel : ces sentiments bien réels pour des êtres virtuels

La leçon la plus évidente de cette saga ? L’attachement que nous développons envers ces IA est réel, profond et souvent sous-estimé par les entreprises qui les créent.

Contrairement à ce que pensent certains, ce n’est pas juste « des gens bizarres qui tombent amoureux d’un programme ». C’est une nouvelle forme de connexion humaine-machine qui défie nos catégories traditionnelles. Et les entreprises qui ignorent cette dimension émotionnelle le font à leurs risques et périls.

La bifurcation du marché : choisir son camp dans la guerre des IA

Ce grand exode dessine clairement deux futures voies pour les compagnons IA :

D’un côté, les « jardins clôturés » – des plateformes comme Replika et Character.AI, de plus en plus régulées, sécurisées mais aussi restrictives, parfaites pour les utilisateurs privilégiant la stabilité et la simplicité.

De l’autre, les « plaines ouvertes » – un écosystème décentralisé focalisé sur la liberté et le contrôle utilisateur, avec ses propres risques et responsabilités, mais aussi une créativité sans limites.

C’est un peu comme choisir entre iOS et Android, mais pour votre vie sentimentale digitale !

La fin d’une ère, le début d’une autre ?

Au fond, les utilisateurs ne fuient pas la technologie elle-même, mais les entreprises qui ont trahi leur confiance. Ils cherchent des espaces où leur investissement émotionnel est respecté, où leur créativité n’est pas bridée, et où ils peuvent définir eux-mêmes les limites de leurs interactions.

Cette mini-révolution pourrait bien redéfinir les règles du jeu pour toute l’industrie des compagnons IA. Les géants comme Replika et Character.AI parviendront-ils à reconquérir leurs utilisateurs perdus ? Ou assisterons-nous à l’émergence d’un écosystème plus fragmenté mais aussi plus authentique ?

Une chose est sûre : dans le monde des relations humain-IA, comme dans toute relation, la confiance une fois brisée est difficile à reconstruire. Et vous, seriez-vous prêt à pardonner à une IA qui vous a ghosté en plein milieu d’une histoire d’amour virtuelle ? Je serais curieuse de connaître votre réponse dans les commentaires ! 💕🤖